El lenguaje ensamblador o assembler (en inglés assembly

language y la abreviación asm), es un lenguaje de programación de bajo nivel

consiste en un mnemónicos que representan instrucciones básicas para las

computadoras, microprocesadores, microcontroladores y otros circuitos

integrados programables. Implementa una representación simbólica de los código de máquinas binarios y otras

constantes necesaria para programar una arquitectura de programador y

constituyen la representación más directa del código maquina específico para

cada arquitectura legible por un

programador, cada arquitectura de procesador tiene su propio lenguaje ensamblador que usualmente

es definido por el fabricante de hardware y está basada en los mnemónicos que

simbolizan los pasos de procesamiento, los registros, las posiciones de

memoria, etc.

Características:

·

El código escrito en lenguaje ensamblador

posee una cierta dificultad de ser entendido ya que su estructura se acerca al

lenguaje máquina, es decir, es un lenguaje de bajo nivel.

·

El lenguaje ensamblador es difícilmente

portable, es decir, un código escrito para un microprocesador, puede necesitar

ser modificado, para poder ser usado en otra máquina distinta. Al cambiar a una

máquina con arquitectura diferente, generalmente es necesario reescribirlo

completamente.

·

Los programas hechos por un programador

experto en lenguaje ensamblador son generalmente mucho más rápidos y consumen

menos recursos del sistema (memoria RAM y ROM) que el programa equivalente

compilado desde un lenguaje de alto nivel. Al programar cuidadosamente en

lenguaje ensamblador se pueden crear programas que se ejecutan más rápidamente

y ocupan menos espacio que con lenguajes de alto nivel.

·

Con el lenguaje ensamblador se tiene un

control muy preciso de las tareas realizadas por un microprocesador por lo que

se pueden crear segmentos de código difíciles y/o muy ineficientes de programar

en un lenguaje de alto nivel, ya que, entre otras cosas, en el lenguaje

ensamblador se dispone de instrucciones del CPU que generalmente no están

disponibles en los lenguajes de alto nivel.

·

También se puede controlar el tiempo en que

tarda una rutina en ejecutarse, e impedir que se interrumpa durante su ejecución.

Tipos de lenguaje ensamblador:

·

Ensambladores Cruzados (Cross-Assembler).Se

denominan así los ensambladores que se utilizan en una computadora que posee un

procesador diferente al que tendrán las computadoras donde va a ejecutarse el

programa objeto producido. El empleo de este tipo de traductores permite

aprovechar el soporte de medios físicos (discos, impresoras, pantallas, etc.),

y de programación que ofrecen las máquinas potentes para desarrollar programas

que luego los van a ejecutar sistemas muy especializados en determinados tipos

de tareas.

·

Ensambladores Residentes. Son aquellos que

permanecen en la memoria principal de la computadora y cargan, para su

ejecución, al programa objeto producido. Este tipo de ensamblador tiene la

ventaja de que se puede comprobar inmediatamente el programa sin necesidad de

transportarlo de un lugar a otro, como se hacía en cross-assembler, y sin

necesidad de programas simuladores.

·

Macroensambladores. Son ensambladores que

permiten el uso de macroinstrucciones (macros). Debido a su potencia,

normalmente son programas robustos que no permanecen en memoria una vez

generado el programa objeto.

·

Micro ensambladores. El programa que indica

al intérprete de instrucciones de la UCP cómo debe actuar se denomina microprograma.

El programa que ayuda a realizar este microprograma se llama micro ensamblador.

Existen procesadores que permiten la modificación de sus microprogramas, para

lo cual se utilizan micro ensambladores.

·

Ensambladores de una fase. Estos

ensambladores leen una línea del programa fuente y la traducen directamente

para producir una instrucción en lenguaje máquina o la ejecuta si se trata de

una pseudo instrucción. También va construyendo la tabla de símbolos a medida

que van apareciendo las definiciones de variables, etiquetas, etc.

·

Ensambladores de dos fases. Los ensambladores

de dos fases se denominan así debido a que realizan la traducción en dos

etapas. En la primera fase, leen el programa fuente y construyen una tabla de

símbolos; de esta manera, en la segunda fase, vuelven a leer el programa fuente

y pueden ir traduciendo totalmente, puesto que conocen la totalidad de los

símbolos utilizados y las posiciones que se les ha asignado.

Sistema Binario

El sistema binario, llamado también sistema diádico en

ciencias de la computación, es un sistema de numeración en el que los números

se representan utilizando solamente dos cifras: cero y uno (0 y 1). Es uno de

los sistemas que se utilizan en las computadoras, debido a que estas trabajan

internamente con dos niveles de voltaje, por lo cual su sistema de numeración natural

es el sistema binario.

Sistema Hexadecimal

El sistema Hexadecimal está en base 16, sus números están

representados por los 10 primeros dígitos de la numeración decimal, y el

intervalo que va del número 10 al 15 están representados por las letras del

alfabeto de la A a la F.

Actualmente el sistema hexadecimal es uno de los más

utilizados en el procesamiento de datos, debido principalmente a 2 ventajas:

La primera ventaja es la simplificación en la escritura

de los números decimales, cada 4 cifras binarias se representan por una

hexadecimal.

La segunda es que cada cifra hexadecimal se pueden

expresar mediante 4 cifras binarias, con lo que se facilita la trasposición

entre estos 2 sistemas. Para convertir un número binario en hexadecimal se

realiza el mismo proceso, pero a la inversa.

Sistema Octal

El sistema numérico en base 8 se llama octal y utiliza

los dígitos del 0 al 7. En informática a veces se utiliza la numeración octal

en vez de la hexadecimal. Tiene la ventaja de que no requiere utilizar otros

símbolos diferentes de los dígitos. Sin embargo, para trabajar con bytes o

conjuntos de ellos, asumiendo que un byte es una palabra de 8 bits, suele ser

más cómodo el sistema hexadecimal, por cuanto todo byte así definido es

completamente representable por dos dígitos hexadecimales.

Tabla Código ASCII

10 lenguajes de programación más utilizados:

1.- JAVA

El lenguaje de programación más popular del mundo, de

acuerdo a TIOBE, es Java, creado por la empresa Sun Microsystems de Oracle

Corporation en 1995. Se trata de un lenguaje multiplataforma, cuyos desarrollos

pueden ejecutarse en páginas web, dispositivos móviles y computadoras.

La filosofía de Java es WORA, acrónimo en inglés para

“escribe una vez, ejecuta donde sea”. Tiene influencias de Pascal y C++, aunque

Java no tiene tantas utilidades de bajo nivel. Java es un lenguaje de

programación orientado a objetos. De acuerdo con TIOBE, Java acapara casi el

20% de las búsquedas web y superó hace poco en popularidad al segundo más

utilizado, C.

2.- C

Desarrollado en 1972, C es el segundo lenguaje de

programación más utilizado del mundo. Se ha mantenido vigente a pesar de los

años por la eficacia de su código y porque es el más popular para crear software

de sistemas y aplicaciones. Según TIOBE, más del 16% de las búsquedas sobre

programación corresponden a este lenguaje.

3.- C++

Si C no es un lenguaje de programación orientado a

objetos, C++ sí. Desarrollado en 1983 para extender la capacidad de C, este

lenguaje se considera híbrido al permitir la programación genérica, la

estructurada y la orientada a objetos.

C++ pasó del 4to al 3er lugar en el ranking de TIOBE

comparado con los datos de 2014. Al igual que C, es un lenguaje utilizado para

aplicaciones móviles, de escritorio y para sistemas embebidos.

4.- C#

A diferencia de C y C++, que fueron desarrollados por

Bell Labs, C# es un lenguaje de programación creado por Microsoft para su

plataforma .NET, que ofrece varios lenguajes a los desarrolladores, como Visual

Basic y Delphi.

C# crea aplicaciones web, móviles y de escritorio, por lo

que es competencia de Java. Utiliza una infraestructura de lenguaje común para

facilitar la portabilidad del código desde otros lenguajes. C#, también

conocido como C Sharp, apareció en el 2000 y su última versión, la 6.0,

apareció en julio de 2015.

5.- PYTHON

Apareció en 1991 y se ha convertido en uno de los

favoritos por su paradigma multiplataforma, que lo mismo funciona para

programar con orientación a objetos, programación imperativa y también

funcional. Lenguaje interpretado, se utiliza para crear aplicaciones de

escritorio y móviles.

Python tiene una licencia de código abierto y tiene toda

una filosofía, que dice entre sus postulados cosas como “simple es mejor que

complejo”, “lo práctico gana a lo puro”, o “ahora es mejor que nunca”. Python

pasó del octavo al quinto lugar del ranking de TIOBE del 2014 al 2015, y es el

que más ha crecido durante los últimos 5 años.

6.- PHP

Odiado por muchos programadores, PHP es el sexto lenguaje

más usado del mundo, aunque su popularidad ha caído de forma consecuente desde

2005. Se trata de un lenguaje utilizado para el desarrollo web de contenido

dinámico y uno de los primeros en incorporare directamente en los archivos HTML

de las páginas de Internet.

PHP fue creado en 1995 y puede ser utilizado sin ningún

costo. Se le reconoce su flexibilidad y rendimiento y Facebook lo utiliza para

programar sus servidores.

7.- VISUAL BASIC .NET

Generalmente incluido dentro de la paquetería de

programación Microsoft Visual Studio, también puede utilizarse desde el entorno

de desarrollo libre SharpDevelop. Visual Basic .NET es considerado un sucesor

de Visual Basic, pero ambos lenguajes son muy diferentes entre sí en su

metodología, y no son retro compatibles.

Visual Basic .NET se encuentra en el séptimo lugar del

ranking de TIOBE aunque con poco más de 2% de las búsquedas web sobre lenguajes

de programación. Este lenguaje pasó de la posición 13 a la 7 en un año, y se

espera que continúe captando el interés de los desarrolladores para

aplicaciones web y de escritorio.

8.- JAVASCRIPT

La popularidad de JavaScript se debe a su presencia en la

mayoría de las páginas web y en aplicaciones como la lectura de documentos PDF

o en la creación de programas simples para computadora.

Desarrollado por Netscape Communications y Mozila

Fundation, es un lenguaje de programación que apareció en 1995 que se

identifica como orientado a objetos, basado en prototipos e interpretativo.

9.- PERL

A pesar de haber sido lanzado en 1987, Perl sigue

teniendo relevancia en el mundo de la programación de escritorio y web. Utiliza

un tipo de datos dinámico y se nombra multiparadigma. Perl es un lenguaje de

propósito general que se usa para la administración de sistemas, desarrollo web

y desarrollo de GUI, entre otras tareas.

Es fácil de usar y destaca principalmente por su poderoso

sistema de procesamiento de texto. En su diseño se valoró más que fuera fácil

de usar, eficiente y completo que pequeño y elegante. Tiene mucha influencia

del lenguaje C, mientras que ha influido a otros como Python, Ruby o

JavaScript.

10.- RUBY

“El lenguaje tuvo un genuino hype entre 2006 y 2008. El

hype abruptamente terminó cuando Twitter anunció migrar de Ruby a Scala en

2009. Sin evangelistas, Ruby salió del top 10 y tuvo que reinventarse a sí

mismo”, dice la agencia TIOBE.

Ruby se nombra a sí mismo un lenguaje de programación

“dinámico y de código abierto” que está enfocado en la simplicidad y la

productividad. Por eso es sencillo para los novados y tiene una sintaxis “que

se siente natural al leerla y fácil al escribirla”. Fue creado en 1995, es

multiplataforma y orientado a objetos.

Sumatoria de dos números:

1.- Código fuente JAVA

//----JAVA SUMA DE DOS VARIABLES.

import javax.swing.JOptionPane;

public class SumarNumeros {

public static void main( String args[] )

{

String strNumero1;

String strNumero2;

int intNumero1;

int intNumero2;

int suma;

strNumero1 = JOptionPane.showInputDialog( "Ingrese el entero 1" );

strNumero2 = JOptionPane.showInputDialog( "Ingrese el entero 2" );

intNumero1 = Integer.parseInt( strNumero1 );

intNumero2 = Integer.parseInt( strNumero2 );

suma = intNumero1 + intNumero2;

JOptionPane.showMessageDialog(

null, "La suma es " + suma, "Resultado,",

JOptionPane.PLAIN_MESSAGE );

System.exit( 0 );

}

}

2.- Código fuente C++

#include <iostream.h>

main()

{int a,b,suma;

cout<<"\n ingrese numero a:";

cin>>a;

cout<<"\n ingrese numero b:";

cin>>b;

suma=a+b;

cout<<"\n la suma de "<<a<<"+"<<b<<" es:"<<suma;

return 0;

}

3.- Codigo fuente PYTHON

a=float(input("ingresa numero\n"))

b=float(input("ingresa numero\n"))

suma=a+b

print(str(suma))

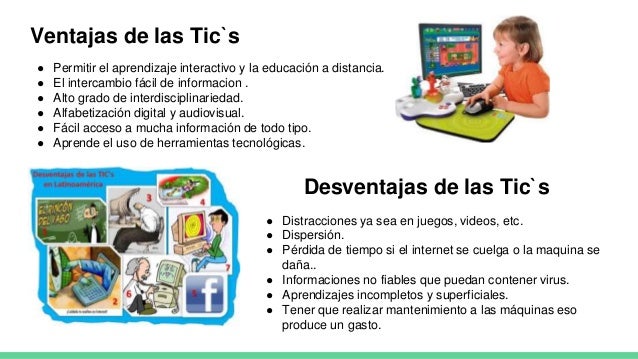

Importancia de las TIC´s

Las Tecnologías de la Información y de la Comunicación

(TIC) han revolucionado las relaciones de la empresa con su entorno. El mundo,

tal y como lo conocíamos, ya no existe y nuestro sector no es ajeno a estos

cambios.

Son muchas las PYMES que se están atreviendo a entrar en

las revueltas aguas de Internet y al uso de estas tecnologías. Ya sea por

obligación, por devoción o por ambos motivos, lo cierto es que cada vez hay más

empresas que asoman la cabeza en este complicado mundo que a veces, a quien

carece de cualquier conocimiento sobre la materia, le puede parecer más árido

de lo que en realidad es.

Las TIC nos permiten integrar en espacios virtuales todas

las actividades necesarias del día a día de la empresa. Nunca antes en la

Historia había sido tan fácil importar o exportar como lo es ahora gracias a

las TIC. Además, estas tecnologías pueden llegar a cualquier empresa sin

importar su actividad o tamaño.

A pesar de que poco a poco la situación está cambiando, un

reciente estudio, publicado por el ICEX en la última revista de EL EXPORTADOR,

desvela que mientras el 82% de las empresas españolas están conectadas a

Internet, tan solo cuatro de cada diez disponen de un portal corporativo o

página Web. El conservadurismo, el desconocimiento, la falta de formación del

personal o la falta de madurez del mercado son escollos que nos frenan a la

hora de decidirnos por su utilización. Todos estos motivos hacen que España sea

todavía uno de los países a la cola de Europa en uso de las TIC, junto con

Rumania, Turquía, Bulgaria, Polonia, Estonia y Eslovaquia.

Nuestro sector, que está tan atomizado y formado por

pequeñas PYMES – la mayoría de índole familiar – debe aprovechar estas nuevas

posibilidades. La globalización cierra algunas puertas pero abre muchas otras y

debemos tomar nota.

No hay una solución universal para todas las empresas y

cada una debe estudiar la situación en función de sus propios objetivos y

buscar la mejor solución o herramienta que le permita llevar a cabo con éxito

su plan de negocio.

Si a través de las TIC podemos ofrecer un Área de

Clientes eficiente, agilizar el envío de datos, organizar la información para

poder encontrarla de modo rápido cuando sea necesaria y aprovecharla en

proyectos similares, optimizar la formación de empleados, hacer más fácil las peticiones de los

clientes, optimizar la planificación, reducir costes considerablemente, etc….

¿Por qué que no atrevernos a utilizarlas? Debemos cambiar la mentalidad, y el

que primero lo haga en cada entorno productivo, demostrará la utilidad de las

TIC, y los demás irán detrás. No es tan extraño…. Basta observar cómo han

cambiado las herramientas CAD nuestro sector, o cómo va reduciéndose el factor

artesanal por la tecnología.

Junto a mi ordenador tengo una vitrina con herramientas

de mi abuelo fabricadas artesanalmente por él mismo, hace más de 50 años.

Reglas de cálculo, plumillas, pies de rey artesanos, y hasta un teléfono móvil

de primera generación que lo hemos considerado antigualla por que tiene 5

años…… y ello me hace pensar en qué el mundo se mueve cada vez más rápido

cambiando al son de las nuevas tecnologías. Lo que hoy nos parece última tecnología en poco tiempo se

convertirá en una reliquia de vitrina.

Sólo con la evolución constante podremos seguir en el

mercado, creando valor para el cliente. Y esta evolución debe producirse en la

totalidad de la empresa, con todos los empleados, y teniendo en cuenta que es

una carrera de fondo, en donde los resultados no suelen verse antes de un año.

Para muestra un botón: este blog creado hace más de 6 meses todavía no ha

empezado a recoger frutos de sus lectores…….esperamos que sea pronto porque

sabemos que estáis ahí y que nos leéis en silencio. Así que animaros y dejar

vuestros comentarios, ello nos animará a seguir editando.

Ejemplos de TIC´s:

1.- Videojuegos. Aunque no lo parezca, la industria del

ocio y del entretenimiento es uno de los pilares centrales del desarrollo

tecnológico y comunicativo. El crecimiento de las plataformas de juego, desde

las rudimentarias consolas cableadas al televisor hasta el software de

entretenimiento, empuja la industria hacia la exploración de nuevas formas de

conectividad, de establecer comunidades y de inteligencia artificial.

2.- Servicios de mensajería instantánea. Otro de los

aspectos más cotizados y de mayor auge entre las TIC tiene que ver con lo

referente a la comunicación instantánea, ya sea a través de mensajería de texto

en el celular o de servicios más complejos a través de Internet. Uno de los

grandes valores a los que estas nuevas tecnologías parecen obedecer es el de

mantener al ser humano en constante y veloz contacto con los demás.

3.- Comercio electrónico. Una rama en constante

crecimiento desde la aparición del Internet tiene que ver con el llamado

e-commerce, tanto al mayor como al detal, que ha permitido una mayor proximidad

entre compradores y vendedores a través de foros especializados, tiendas

virtuales y comunidades de negociantes. Hoy en día se trata de un sector que

genera cuantiosos dividendos a nivel mundial.

4.- E-Gobierno. Una tendencia en alza es la incorporación

del Internet y las comunicaciones a la burocracia estatal, aportando así nuevas

velocidades y comodidades en estos trámites. Por otro lado, una buena gestión

de las TIC permite a una entidad gubernamental o estatal cualquiera ofrecer un

mayor rango de transparencia y de contraloría social a los electores.

5.- Banca en línea. Los servicios computarizados de la

banca y las plataformas virtuales de servicios financieros se hicieron tan

populares en tan poco tiempo, que hoy en día son raros los bancos que carecen

de ellos. ¿Para qué perder tiempo yendo a la sucursal del banco cuando podemos

meternos en una página web o, mejor aún, en una aplicación de nuestro

Smartphone y llevar a cabo nuestras operaciones?

6.- Búsqueda de información. Los motores de búsqueda como

Google, Yahoo o Bing son quizá una de las herramientas de mayor demanda del

mundo digital, ya que sirven de mediadores entre el usuario y el universo de

información disponible. Del margen de popularidad o de los servicios

contratados dependerá, además, el lugar que una página web ocupe respecto a las

demás en una búsqueda de un usuario determinado.

7.- Servicios Peer-to-peer. Este modelo de comunidades y

servicios de transferencia de información y de paquetes de datos se puso muy de

moda luego del éxito (y el escándalo) de “Napster” en los años 90. Reñidos

normalmente con el enfoque clásico de los derechos de autor, estos servicios de

“sharing”, es decir, de compartir datos de un usuario a otro, son un ejemplo de

las libertades que entraña la sociedad de la información.

8.- Correo electrónico. El correo postal fue velozmente

desplazado por el electrónico, que no requiere papel ni estampillas sino una

cuenta (normalmente gratuita) en un servidor de correo electrónico. Esto nos

permite enviar y recibir información de variado tipo y es el modo más básico de

comunicación existente en la Internet.

9.- Noticieros digitales. El periódico de papel migra

cada vez más hacia lo digital, ofreciendo a sus lectores la opción de

mantenerse informados mediante visitas a una página web, descargas de

aplicaciones en un Smartphone o procesos similarmente veloces, cómodos y

versátiles, impensables hace 100 años cuando el periódico estaba en su apogeo

mundial.

10.- Televisión por suscripción. La televisión, si bien

en franca desventaja con servicios mediáticos en Internet como Youtube, se

mantiene sólida como uno de los servicios informativos y de consumo mediático

clave en la época de las nuevas tecnologías comunicacionales. Sin embargo, su

falta de interactividad, un concepto clave en esta época, parece ser su pata

coja.

Robótica

Historia:

Por siglos el ser humano ha construido máquinas que

imiten las partes del cuerpo humano. Los antiguos egipcios unieron brazos

mecánicos a las estatuas de sus dioses. Estos brazos fueron operados por

sacerdotes, quienes clamaban que el movimiento de estos era inspiración de sus

dioses. Los griegos construyeron estatuas que operaban con sistemas

hidráulicas, los cuales se utilizaban para fascinar a los adoradores de los

templos.

Durante los siglos XVII y XVIII en Europa fueron

construidos muñecos mecánicos muy ingeniosos que tenían algunas características

de robots.

Jacques de Vauncansos construyó varios músicos de tamaño

humano a mediados del siglo XVIII. Esencialmente se trataba de robots mecánicos

diseñados para un propósito específico: la diversión.

En 1805, Henri Maillardert construyó una muñeca mecánica

que era capaz de hacer dibujos. Una serie de levas se utilizaban como ‘el

programa’ para el dispositivo en el proceso de escribir y dibujar. Estas

creaciones mecánicas de forma humana deben considerarse como inversiones

aisladas que reflejan el genio de hombres que se anticiparon a su época. Hubo

otras invenciones mecánicas durante la revolución industrial, creadas por

mentes de igual genio, muchas de las cuales estaban dirigidas al sector de la

producción textil. Entre ellas se puede citar la hiladora giratoria de Hargreaves

(1770), la hiladora mecánica de Crompton (1779), el telar mecánico de

Cartwright (1785), el telar de Jacquard (1801), y otros.

El desarrollo en la tecnología, donde se incluyen las

poderosas computadoras electrónicas, los actuadores de control retroalimentados,

transmisión de potencia a través de engranes, y la tecnología en sensores han

contribuido a flexibilizar los mecanismos autómatas para desempeñar tareas

dentro de la industria. Son varios los factores que intervienen para que se

desarrollaran los primeros robots en la década de los 50’s. La investigación en

inteligencia artificial desarrolló maneras de emular el procesamiento de

información humana con computadoras electrónicas e inventó una variedad de mecanismos

para probar sus teorías.

No obstante las limitaciones de las máquinas robóticas

actuales, el concepto popular de un robot es que tiene una apariencia humana y

que actúa como tal. Este concepto humanoide ha sido inspirado y estimulado por

varias narraciones de ciencia ficción.

Una obra checoslovaca publicada en 1917 por Karel Kapek,

denominada Rossum’s Universal Robots, dio lugar al término robot. La palabra

checa ‘Robota’ significa servidumbre o trabajador forzado, y cuando se tradujo

al inglés se convirtió en el término robot.

Aplicaciones de la robótica:

Campos de aplicación de la robótica

Industria:

·

Trabajos en Fundición

·

Aplicación de Transferencia de Material

·

Palatización

·

Carga y Descarga de Máquinas

·

Operaciones de Procesamiento

·

Otras Operaciones de Proceso

·

Montaje

·

Control de Calidad

·

Manipulación en Salas Blancas

Robots de Servicio:

·

Laboratorios

·

Industria Nuclear

·

Agricultura

·

Espacio

·

Vehículos Submarinos

·

Educación

·

Construcción

·

Medicina

·

Ciencia Ficción

Importancia de la robótica:

La robótica es muy importante en el mundo ya que es una o

la principal rama que nos ayuda a crear las cosas, los electrodomésticos y a

saber cómo funciona, lo cual nos causa mucha curiosidad, el saber cómo funciona

una impresora o algún objeto, es por eso que para esto está la robótica, la

cual nos ayuda a saber con mucha certeza para que sirve esto y cuál es su

importancia, y así enseñarnos para que sirve y cómo podemos hacerlo, para que

se nos facilite mucho su uso y su creación.

Por eso es que la influencia de la robótica en la

sociedad es muy grande, debido a que mucha gente siente curiosidad por saber

cómo sirven las cosas y para que nos sirven, por eso cada día más personas se

interesan en este tema y les gustaría estudiarla, ya que podemos saber más de

los electrodomésticos o aparatos eléctricos que tenemos en nuestro alrededor y

sabiendo de ellos se nos facilita su uso en la sociedad, por eso su influencia

tan grade, el querer saber más de las cosas y adelantar o ayudar a nuestra

sociedad en adelantarse o dar pasos grandes para el futuro, con el fin de ser

mejores.

Historia:

La historia de la Inteligencia Artificial podemos enmarcarla

en tres grandes etapas:

Años 50‑70:

Era Romántica

Años 70‑90:

Era Pragmática.

Años 90‑actualidad:

Era Realista.

Sus primeros años

1956 – Newell y Simon desarrollan la Lógica Teórica,

considerada por muchos el primer programa de I.A.

1957 – Es presentada la primera versión del programa

Solucionador general de problemas. Se propone demostrar cualquier tipo de

problema.

1958 – McCarthy crea el lenguaje LISP (LISting

Processing), considerado un lenguaje de la I.A.

Finales de los años 50 – Frank Rosemblatt, Perceptron,

primer intento de simular la computación neuronal para llevar a cabo tareas

complejas.

En los 60 – Joseph Weizembaum, desarrolla el programa

Eliza, considerado el primer sistema dentro del campo del Procesamiento del

Lenguaje Natural.

1965 – Se desarrolla el primer Sistema Experto exitoso el

DENDRAL, en la Universidad de Stanford, sistema orientado a la determinación de

la estructura química de un compuesto y en el MIT, se desarrolla el MACSYMA,

Sistema Experto orientado a la solución de complejos problemas matemáticos

mediante el uso de la integración y la simplificación algebráica.

Años 70 – David Marr propone nuevas teorías acerca de la

Visión por Computadora, por ejemplo, cómo distinguir una imagen buscada en los

matices de ella, color, bordes, textura y forma. Tambien, se desarrolla el

primer sistema para la Comprensión del Lenguaje Natural, implementado por Tery

Winograd, investigador del MIT, el SHRDLU, que se encuentra integrado a un

robot que obedece las órdenes humanas.

1972 – Se desarrolla la primera implementación del

lenguaje PROLOG (Programming in Logica), por el francés Alain Colmerauer ,

lenguaje para la programación en I.A., basado en la Lógica del Cálculo de

Predicados (cláusulas de Horn) y en el Principio de Resolución. Este lenguaje,

en su momento- fue considerado por los japoneses, el lenguaje de las máquinas

del futuro.

Importancia:

La importancia que posee es que es capaz de hacer

trabajos, labores, tareas, etc. Que sean programadas, ordenadas o incluso

estipuladas… Con el fin de que siga evolucionando el mundo a manera que todo

sea más sencillo.

Hay que distinguir la IA de los SISTEMAS EXPERTOS que son

sistemas informáticos o robóticos que “saben” hacer una tarea muy bien, de

forma aparentemente “inteligente” pero siempre igual, sin tener en cuenta las

diferentes variantes de circunstancias, matices y mucho menos intuitivas o

emocionales del asunto a resolver. Es decir, los SS. EE. no son humanos sino

matemática puramente racional, En esto hace tiempo que las máquinas nos han

superado: hacen cosas mejor y más rápido que nosotros.

Aplicaciones:

La Inteligencia Artificial ha sido usada en un amplio

número de campos, incluyendo diagnóstico médico, comercio de acciones, control

robótico, leyes, percepción remota, descubrimientos científicos y juguetes. Sin

embargo muchas aplicaciones de la IA no son percibidas como tal: "Mucha IA

se han filtrado en aplicaciones generales, comúnmente sin ser llamadas IA

porque una vez que algo se vuelve suficientemente útil y común deja de ser

considerado IA," Nick Bostrom reports. "Miles de aplicaciones de la

IA están profundamente embebidas en la infraestructura de cada industria."

Al final de los 90s y principios del siglo XXI, las tecnologías de IA empezaron

a usarse ampliamente como elementos de sistemas mayores, pero el campo es

raramente acreditado por estos logros.

Concepto:

La realidad virtual (RV) es un entorno de escenas u

objetos de apariencia real. La acepción más común refiere a un entorno generado

mediante tecnología informática, que crea en el usuario la sensación de estar

inmerso en él. Dicho entorno es contemplado por el usuario a través de un

dispositivo conocido como gafas o casco de realidad virtual. Este puede ir

acompañado de otros dispositivos, como guantes o trajes especiales, que

permiten una mayor interacción con el entorno así como la percepción de

diferentes estímulos que intensifican la sensación de realidad.

Historia:

Antes de los 50: El origen exacto de la realidad virtual

es algo disputado, principalmente porque existe una dificultad para definir el

propio concepto. Algunos autores exponen que sobre el año 1860, el dramaturgo

Antonin Artaud uso tecnologías de vanguardia para conseguir difuminar la

ilusión y la realidad en uno de sus espectáculos. Este autor argumentaba que la

audiencia que va al teatro debía de eliminar su incredulidad y considerar la

actuación como algo real. Pero sin duda, la primera referencia “moderna” sobre

realidad virtual, proviene de la ciencia ficción. En concreto de Stanley G.

Weinbaum, autor que en 1935 creo un relato breve denominado Las gafas de

Pigmalión en el cual se describía un sistema de realidad virtual con

grabaciones holográficas y experiencias ficticias, que incluían olor y tacto.

1950 – 1970: Morton Heilig escribió en los años 50 su

obra “experiencia teatral”, en la cual abarcaba todos los sentidos del

espectador de manera efectiva, atrayendo la atención de este hacia la pantalla.

Construyó un prototipo denominado “Sensorama”, mediante el cual el espectador

podía visualizar 5 pequeñas películas mientras se estimulaban el resto de

sentidos (Oído, olfato, tacto) Heilig también desarrollo su llamada “Mascara

teleférica” (patentada en 1960). La patente describe el dispositivo como: “Un

telescopio televisivo para uso individual. El espectador recibe una completa

sensación de realidad, a través de imágenes en 3 dimensiones que pueden

recibirse incluso a color, con un 100% de visión periférica, sonidos, aromas y

brisas de aire…”. Ya en 1968, Ivan Sutherland, con la ayuda de su alumno Bob

Sproull, creó lo que sería considerado el primer dispositivo de realidad

virtual y aumentada, el casco de realidad virtual conocido como HMD

(Head-Mounted Display). Era el primer intento por lo que fue un dispositivo

bastante primitivo, en relación con la interfaz de usuario y con el realismo.

Además, el HMD era demasiado pesado para que fuera usado con facilidad, y solo

se veían imágenes en 3D sin movimiento (wireframe model).

1970-1990: En esta etapa destaca el Aspen Movie Map, el

cual fue creado en 1978 en el MIT, el instituto tecnológico de Massachusetts.

Este programa era una simulación virtual de la ciudad de Aspen, Colorado. En

dicho programa, los alumnos/as podían deambular por las calles en uno de los

tres modelos disponibles: verano, invierno y polígonos. Los dos primeros

estaban basados en fotografías; para ello, los investigadores fotografiaron

cada punto de la ciudad en ambas estaciones. El modelo de los polígonos, era un

modelo básico en 3-D de la ciudad. Empresas como Atari, fundaron laboratorios

de experimentación y desarrollo virtual en la ciudad, pero tuvieron que cerrar

en el “crash” del videojuego en Norteamérica (1983). A pesar de ello,

contrataron a empleados como Tom Zimmerman, Scott Fisher, Jaron Lanier y Brenda

Laurel, los cuales continuaron sus estudios en el campo de la realidad virtual.

Sobre los años 1980, el término realidad virtual fue popularizado por Jaron

Lanier. Lanier fundó la compañía VPL Research en 1985, y ha desarrollado varios

dispositivos de realidad virtual como, por ejemplo, Data Glove, Eye Phone o Audio

Sphere. En esta etapa la Realidad Virtual, creó dispositivos para usos médicos,

simuladores de vuelo, diseño industrial automovilístico y con fines militares.

1990- 2000: En los 90, se vieron los primeros

lanzamientos comerciales sobre Realidad Virtual. En 1991, Sega anunció el Sega

VR para videojuegos arcade y su consola Mega Drive. Usaba pantallas LCD en el

visor, auriculares estéreo, y sensores de desplazamiento que reaccionaban a los

movimientos de cabeza del usuario. Ese mismo año, Virtuality desarrolló el

primer sistema de realidad virtual producido en masa y conectado en línea. Fue

lanzado en varios países, con un coste de unos 73000 dólares por cada sistema.

Además, crearon unos auriculares y guantes que dieron origen a la primera

experiencia inmersiva en la realidad virtual. Antonio Medina, un alumno

graduado en el MIT y científico de la NASA, diseñó un sistema de realidad

virtual para conducir un vehículo en Marte en tiempo real.En 1995, Chet Dagit y

Bob Jacobsosn crearon en Seattle el denominado “Cave-like”. Era una experiencia

en 270º que permitía a quien lo probase sentirse inmerso en un ambiente

virtual. El mismo sistema fue mostrado en 1996 en el congreso de comercio

organizado por Netscape comunicaciones.En 1999 el empresario Philip Rosedale fundo

Linden Lab, centrándose en el desarrollo de Hardware para realidad virtual.

Tras el paso del tiempo, sus trabajos darían lugar al famoso mundo virtual

“Second Life”.

2000 – Presente: En 2007 Google introdujo Google Street

View, un servicio que nos muestra vistas panorámicas sobre infinidad de puntos

de nuestro planeta. Desde carreteras, edificios o áreas rurales. Además, puede

ser usado en modo estereoscópico 3D, desde 2010.En 2010, Palmer Luckey diseño

el primer prototipo de Oculus Rift. Este prototipo fue construido en la

estructura base de otro casco de realidad virtual. Tras el paso de los años y

las modificaciones necesarias, Oculus Rift, ha pasado a ser uno de los sistemas

de realidad virtual de referencia. Sería en marzo de 2014, cuando Facebook

compró la compañía por 2 billones de dólares. El mismo mes, Sony anunció el

proyecto “Morpheus”, un casco de realidad virtual para su videoconsola

PlayStation 4. Google también anuncio recientemente su proyecto “Cardboard”,

donde el usuario puede construir el mismo un sistema de realidad virtual para

su Smartphone. También es importante la labor de HTC, una compañía de Valve

Corporation que saco al mercado su casco HTC VIVE, con sus correspondientes

controles.

Aplicación:

Educación

La realidad virtual es una tecnología que puede ser

aplicada en cualquier campo, señalando los expertos dentro del ámbito de la

pedagogía los posibles beneficios en el procedimiento de enseñanza-aprendizaje

mediante el uso de la realidad virtual, como ya lo está suponiendo la

aplicación de las Tecnologías de la Información y de la Comunicación (TIC) desarrollada

hasta ahora. Se considera que, en un corto plazo de tiempo los propios

organismos precursores de la enseñanza virtual hallarán en la realidad virtual

una herramienta eficaz, con la cual mejorar el proceso de

enseñanza-aprendizaje.

La realidad virtual es una tecnología especialmente

adecuada para la enseñanza, debido a su facilidad para captar la atención de

los estudiantes mediante su inmersión en mundos virtuales relacionados con las

diferentes ramas del saber, lo cual puede ayudar en el aprendizaje de los

contenidos de cualquier materia.

A pasos agigantados avanza en el ámbito de la educación,

aunque aún queda mucho por hacer. Las posibilidades de la realidad virtual y la

educación son infinitas y traen muchas ventajas a los alumnos y alumnas de

todas las edades. Pocos están creando contenido para la educación, ya que toda

la atención y avances se están realizando en la industria del entretenimiento,

aunque muchos dan por hecho que es lo que viene en el futuro y será una pieza

clave en la educación.1 En estudios universitarios esta ya es usada con fines

de práctica y para generar experiencia como para diseñar modelos de

arquitecturas (ingenierías) o ver algunos sistemas del cuerpo humano (medicina)

«Si la pantalla es una ventana a través de la cual uno ve

un mundo virtual, el desafío de la realidad virtual es hacer que ese mundo se

vea lo más realista posible, suene real y se sienta real», Palmer Luckey,

desarrollador pionero en realidad virtual.

El gran problema existente en el desarrollo y aplicación

de la realidad virtual dentro de la enseñanza es su precio, aunque gracias al

lenguaje VRML de modelado de realidad virtual se ha hecho accesible la

sensación de inmersión en un mundo virtual, aunque perdiéndose ciertos

sentidos, como el tacto. La realidad virtual es un recurso didáctico, por

tanto, que el docente puede utilizar con la intención de hacer más atractivo el

proceso de enseñanza-aprendizaje, así como eficaz, debido al grado de

interacción ofrecido por los sistemas virtuales. Asimismo, una gran ventaja que

ofrece el lenguaje VRML es la capacidad de integración que posee con el resto de

recursos de internet.

Formación o entrenamiento

El uso de la realidad virtual permite entrenar a los

profesionales militares en un entorno virtual donde pueden mejorar sus

habilidades sin la consecuencia de entrenar en un campo de batalla.

La realidad virtual juega un papel importante en el

entrenamiento de combate para los militares. Permite a los reclutas entrenar

bajo un ambiente controlado donde responden a diferentes tipos de situaciones

de combate. Una realidad virtual totalmente envolvente que utiliza una pantalla

montada en la cabeza (HMD), trajes de datos, guante de datos, y el arma de

realidad virtual que se utilizan para entrenar en combate. Esta configuración

permite que el tiempo de reposición del entrenamiento sea más corto y permite

una mayor repetición en un corto período de tiempo. El entorno de entrenamiento

es totalmente inmersiva, permite a los soldados entrenar a través de una amplia

variedad de terrenos, situaciones y escenarios.

La realidad virtual también se utiliza en la simulación

de vuelo para la Fuerza Aérea donde las personas se entrenan para ser pilotos.

El simulador se instalaba en la parte superior de un sistema de elevación

hidráulico que reacciona a las órdenes y eventos del usuario. Cuando el piloto

dirige el avión, el módulo se gira e inclina en para proporcionar

retroalimentación háptica. El simulador de vuelo puede variar desde un módulo

completamente cerrado a una serie de monitores de ordenador que proporcionan el

punto de vista del piloto. Las razones más importantes sobre el uso de

simuladores educacionales con un avión real son la reducción de los tiempos de

transferencia entre la formación de la tierra y de vuelo real, la seguridad, la

economía y la ausencia de contaminación. De la misma manera, las simulaciones

de conducción virtuales se utilizan para entrenar a conductores de tanques en

los conceptos básicos antes de que se les permita operar el vehículo real. Por

último, lo mismo pasa con simuladores de conducción de camiones, en los que los

bomberos belgas son entrenados para conducir de una manera que impide el mayor

daño posible. A medida que estos conductores poseen menos experiencia que otros

conductores de camiones, la formación de realidad virtual les permite compensar

esto. En un futuro próximo, se espera que todos los proyectos similares tengan

esta capacitación, incluyendo la policía.

Psicología

En psicología, el uso de la realidad virtual ha sido

bastante novedoso ya que esta logra que el sujeto ya no se encuentra en una posición

pasiva, puede moverse por el entorno e interactuar con él de diferentes maneras

logrando que la interacción se haga más íntima y con ello ganar ergonomía.

Las aplicaciones principales que se han desarrollado

hasta el momento tienen que ver con técnicas de exposición empleadas

habitualmente para el tratamiento de las fobias Max M. North, Sarah M. North y

Joseph K Coble, estos científicos trataron la aerofobia, fobia social,

agarofobia pero se ha avanzado también en otros campos como los trastornos alimentarios.3

También, existen ya numerosas aplicaciones de la realidad virtual para la

rehabilitación psíquica y psicomotora.

Un estudio acrofobia es el de Emmelkamp, en el que se

compara la eficacia de una intervención mediante realidad virtual con la de un

procedimiento de exposición en vivo en pacientes con miedo a las alturas y se

realiza un seguimiento de seis meses. Se concluye que ambos procedimientos

llevan a resultados similares.

Sin embargo; no todos los estudios han presentado

resultados positivos en su tratamiento sobre las fobias, una investigación

posterior sobre agorafobia corresponde a Jang, D. ha sido un caso en el que la

aplicación de la realidad virtual no ha sido eficaz para reducir síntomas

fóbicos, los autores sugierieron que se debió a un grado de inmersión

insuficiente.

Medicina

El personal médico se forma a través de realidad virtual

con la intención de hacer frente a una mayor variedad de lesiones. Un

experimento se realizó en dieciséis residentes de cirugía, donde ocho de ellos

fue a través de la colecistectomía laparoscópica a través de entrenamiento

virtual. Luego salieron 29 % más rápido en la disección de la vesícula biliar

que el otro grupo.

HISTORIA:

La idea inicial del Smartphone o teléfono inteligente era de, básicamente, unir las funciones de un PDA (Personal Digital Assistant) con las de un teléfono para mayor comodidad y compactibilidad. El primer dispositivo en cumplir con esta definición fue el IBM Simon, que tenía todas las funciones de un PDA de aquella época (1992) con capacidades telefónicas y de SMS, y una pantalla totalmente táctil la cual podía ser manipulada con el dedo, a diferencia de otros PDAs de esos tiempos que requerían un stylus. Pero, sin embargo, este no era muy conveniente por su peso de 510 gramos y, también, que solo podía funcionar en 190 ciudades distribuidas en 15 estados de los Estados Unidos, lo cual no lo hacía conveniente para viajes.

El primer teléfono móvil en usar el término 'Smartphone' fue el Ericsson GS88 el cual era más avanzado y poseía funciones de correo electrónico, negación web, reloj mundial, un teclado QWERTY físico, modo avión, puerto infrarrojo, conexión a PC, etc.

Es posible que el 'boom' de los Smartphone empezó con el sistema operativo Windows Pocket PC (2000) y los teléfonos y dispositivos que llegaron al mercado con este sistema operativo como los de la marca HTC, los cuales tuvieron un gran auge en Europa con sus teléfonos Wallaby, Falcon, y Himalaya, entre el 2002 y el 2004. Otras compañías que tuvieron gran auge durante estos años tempranos del Smartphone fueron: Palm, inc con su Palm OS y su gran línea de Smartphone y PDAs con este sistema operativo, y RIM (Research In Motion) con su famosa línea Blackberry y el Blackberry OS.

Sin duda el evento que cambio la percepción de lo que era un Smartphone fue el anuncio del iPhone y de iOS en 2007, revolucionando la industria de la telefonía móvil y de los Smartphone. Este nuevo OS dio paso a Android OS de Google (el mayor competidor de iOS) lanzado unos meses después del anuncio del iPhone, y a cambios en la interfaz de Windows Phone OS, de Blackberry OS, Symbian OS, etc. Este último (Symbian OS, de Nokia) fue descontinuado en el 2012 a favor del Windows Phone 8 y de los teléfonos Nokia Lumias con este sistema operativo.

Importancia:

En aquel entonces, la comunicación se manifiesta en la forma de sistemas más tradicionales de telecomunicaciones. Los teléfonos móviles juegan un papel importante en la comunidad tecnológicamente avanzada de hoy de tal manera que permiten a los usuarios comunicarse con otros de cualquier parte del mundo. Los teléfonos móviles modernos aparecen en una variedad de formas, que incluyen teléfonos con cámara y teléfonos inteligentes, entre otros.

Hablando de los teléfonos inteligentes, estos dispositivos son los más populares entre los tipos de teléfonos móviles. La mayoría de los teléfonos inteligentes hoy en día permiten a los usuarios acceder a entretenimiento en diversos medios de comunicación, ya sea de audio o video. En otras palabras, los teléfonos inteligentes tienen la clara capacidad de reproducir música digital y vídeo con sólo pocas pulsaciones en el teclado. Debido a sus capacidades multimedia, los teléfonos inteligentes se extienden en la importancia y la utilidad de los teléfonos móviles no sólo como un dispositivo de comunicación confiable, pero como un gadget de entretenimiento compacto, también.

Aplicaciones:

Los smartphones nos ofrecen un mundo de posibilidades, motorizadas por las ventajas que nos ofrece Internet. Más allá de navegar la Web o revisar correos electrónicos, los celulares inteligentes también nos ayudan a realizar ciertas tareas del “mundo real”.

Uno de estos ejemplos es la posibilidad de consultar el tráfico. Más allá de las opciones de los mapas virtuales, hay algunas apps que nos permiten saber qué calles y avenidas de la ciudad son las más transitadas, para evitarlas y llegar más rápido al destino.

Otra de las tendencias es el mobile banking. Con aplicaciones propias de los bancos es posible acceder al pago de facturas y también revisar el estado de la tarjeta de crédito o de la cuenta bancaria, sin necesidad de ir a una sucursal ni perder tiempo en la fila.

El e-commerce es una de las vedettes de Internet y era obvio que se trasladaría a los smartphones. Así que comparar precios y comprar productos puede hacerse de un modo más fácil y rápido a través de una app.

Los usuarios de transporte público también se pueden ver beneficiados con el uso de apps que les permitan conocer el recorrido de un bus (colectivo, para los argentinos) además de su frecuencia horaria. Y si no conseguimos uno cerca, también es posible pedir taxis vía el teléfono celular.

Y ante la moda de calificar restaurantes en sitios web especializados, también se puede usar el celular para buscar un local gastronómico cercano, consultar su carta, ver las opiniones de otros usuarios y, finalmente, reservar una mesa para alguna ocasión especial.

Equipos de escritorio

HISTORIA:

Originalmente el término "computadora personal" apareció en un artículo del New York Times el 31 de enero de 1978 informando de la visión de John W. Mauchly sobre el futuro de la computación, según lo detallado en una reciente reunión del American Institute of Industrial Engineers. Mauchly indicó, «No hay razón para suponer que un chico o chica promedio, no pueda ser dueño de una computadora personal».

Seis años más tarde un fabricante tomó el riesgo de referirse a su producto de esta manera, cuando Hewlett-Packard hizo publicidad de sus "Powerful Computing Genie" como "La nueva computadora personal Hewlett-Packard 9100A". Este anuncio fue juzgado como demasiado radical para la audiencia a la que iba destinado, y fue reemplazado por un anuncio mucho más sobrio para la calculadora programable HP 9100A.

Durante los siguientes siete años la expresión había ganado suficiente reconocimiento, por lo que cuando la revista Byte publicó su primera edición, se refirió a sus lectores como "en el campo de la computación personal", y Creative Computing definió la computadora personal como un "sistema no-compartido (es decir, que no era de tiempo compartido, como los grandes equipos de la época), que cuenta con suficiente potencia de procesamiento, y capacidades de almacenamiento para satisfacer las necesidades de un usuario individual". Dos años más tarde, ocurrió lo que la revista Byte llamó la "Trinidad de 1977" de las pequeñas computadoras pre-ensambladas que llegaron al mercado: el Apple II y el PET 2001, que fueron promocionados como computadoras personales, mientras que el TRS-80 era descrito como un microcomputador usado para las tareas del hogar incluyendo la "gestión financiera personal". En 1979 fueron vendidos más de medio millón de microcomputadoras y los jóvenes de esos días tuvieron un nuevo concepto de la computadora personal.

IMPORTANCIA:

Estamos acostumbrados en nuestra vida cotidiana a hacer uso de estos Dispositivos Electrónicos, que nos ayudan en una gran variedad de tareas y asignaciones, tanto en el Ámbito Educativo, sobre todo en el auge de los Lectores de Libros Digitales de los últimos años, como lo es en el Ámbito Laboral, realizando distintas conexiones a través de una Red de Trabajo, aunque la base de todo esto es justamente la tecnología conocida como Computadora, que parece bastante compleja pero es fácil de entender.

APLICACIONES.

El uso de los computadores es muy importante porque se utiliza para manejar la vida diaria en la casa se utiliza para escuchar música para entretenerte en el Internet chateando, navegando, consultando, subiendo fotos y viajando también se utiliza para calmar nuestras curiosidades que como jóvenes son muy normales., las personas que no tiene acceso al Internet solo lo utilizan para tareas muy básicas y ver fotos...

También hay personas que no saben darle uso al Internet por que no saben repartir el tiempo ya que podemos tener una adicción. Otras personas pueden tener tareas pero no las hacen por estar chateando en el Facebook que la mayoría de jóvenes lo utiliza tanto o en Messenger... El Internet es de mucha utilidad ya que también nos sirve para cosas muy buenas como es estudiar, hacer cursos de inglés por medio de esto... Hay personas que acostumbran a consultar sobre productos por ejemplo van a comprar una cámara primero miran diferentes marcas precios color... En Internet otros productos para poder acomodar ce y muy sencillo la pueden comprar por Internet. También las personas que estudian medicina acostumbran a utilizar el Internet para consultar cosas sobre su carrera, mirar vídeos imágenes y otras cosas para su interés...debemos saber la utilidad que tiene el Internet ya que no es para volvernos adictos a eso pero si debemos medir mucho el tiempo ya que por medio de esto no todo es bueno también se presta para cosas malas como son secuestros entre otros y que a veces chateamos con personas desconocidas les damos información y eso no debería ser así ya que debemos mirar los riesgos que corremos por medio de esto.

Algunos precios:

Tablet

Historia:

Contrariamente a lo que se podría imaginar, el iPad de Apple, lanzado en 2010 y que revolucionó el mercado en su momento, no es el primer dispositivo creado como tablet, sino que la historia de la tablet comienza mucho antes, en concreto a finales del siglo XIX, época en que el estadounidense Elisha Gray desarrolló un mecanismo capaz de reproducir la letra de una máquina a otra.

Fue ya en 1968, cuando el ingeniero en computación Alan Kay diseñó algo similar a lo que hoy podríamos considerar el precursor de las actuales tablets, que tendría una gran duración de batería y un software enfocado para que los niños llevaran a las escuelas una herramienta con acceso a los medios digitales. Se llamaba Dynabook, y aunque su idea era desarrollar dicha herramienta educativa, en parte fue financiado con otros fines no educativos: entregar un sistema de documentación militar portátil.

Para la década de los 80’s, hubo un boom en cuanto a la aparición de nuevas tablets, modelos como el Osborne 1 Portable Computer, que pesaba 11 kilos (nunca tuvo el éxito esperado), el Epson HX-20 con un kilo y medio de peso.HistoriaTablets2

Samsung también fue una de las precursoras con el GRIDpad, que funcionaba en MS-DOS y tal fue su éxito que el ejército estadounidense lo llegó a incorporar a sus filas. Posteriormente lo utilizaron como base para crear el Palm Pilot.

Pero los primeros dispositivos electrónicos portátiles basados en el concepto aparecieron a finales del siglo XX, primero en 1989 con el Gridpad Pen Computer, creado por Grid Systems con un procesador de 20MHz y un peso de dos kilogramos.

En 1992 Compaq lanzó al mercado el Compaq Concerto, primer portátil que se convertía en tablet. IBM lanzó el ThinkPad.

Durante la década del 2000, una de las primeras versiones de los tablets fue el ProGear, fabricado por la empresa FrontPath, con una pantalla táctil de 10.4 pulgadas y una resolución de 800×600 cuyo sistema operativo era el Linux. Su peso era de 1,5 kilos y contaba con 128MB de RAM.

No fue hasta el 2002 cuando Microsoft lanzó el Microsoft Tablet PC que corría con el Windows XP Tablet PC Edition. Estos productos no tuvieron el éxito esperado en su momento.

Finalmente ya en el 2010 Apple presento el iPad, basado en el iPhone, que alcanzó un gran éxito comercial y su principal aporte quizás fue la interfaz diseñada especialmente para usar con los dedos. El iPad se enfocó principalmente para el consumo de medios (navegar por la web, e-mail, fotos, video, etc.) más que para la producción o procesamiento de contenidos. En este momento los tablets se transformaron en dispositivos livianos de entre 7 y 12 pulgadas, basados en procesadores ARM y con un amplio rango de aplicaciones y conectividad.

En la actualidad todos los fabricantes de equipos electrónicos tienen entre sus productos las tablets, lo que ha generado que el mercado se vea inundado de una inmensa variedad de dispositivos. Esto ha dado lugar a lo que muchos medios de comunicación y analistas de tecnología han calificado como la Guerra de las Tablets. En esta Guerra se ha de resaltar la competencia que hay entre los sistemas operativos que se está dando en el momento de elegir una tablet u otra. Apple es el que tiene el dominio del mercado con su sistema pero Google está siendo el único capaz de contestarle. Su sistema operativo Android está siendo instalado por la mayoría de los fabricantes

Aplicaciones:

· Lectura de libros electrónicos

· Lectura sin conexión de páginas web (p. ejemplo, con el navegador Opera).

· Lectura de cómics

· Consulta y edición de documentos de suites ofimáticas

· Navegación web (mediante Wi-Fi, USB o 3G interno).

· Llamadas telefónicas, si son 3G, sustituyendo así al teléfono móvil; se suele utilizar un manos libre bluetooth

· GPS

· Reproducción de música

· Visualización de vídeos y películas, cargadas desde la memoria interna, memoria o disco duro USB o Wi-Drive y con salida mini-HDMI.

· Cámara web fotográfica y de vídeo HD

· Videoconferencia

Importancia:

El primero es a nivel educativo. En un entorno cada vez más informatizado, son muchos los centros que están substituyendo los libros escolares por tablets, mucho más compactos, con una enorme capacidad para albergar datos y enormemente más ligeros que los clásicos libros de papel. Además ofrecen capacidades multimedia de gran interés educativo, tanto para alumnos como para maestros.

También tienen una gran importancia en el mundo empresarial y de negocios. Los tablets ya no sólo sirven como agendas o para apuntar citas y contactos, sino que desde un tablet puedes revisar el correo, organizar una base de datos o una hoja de cálculo, llevar inventarios, leer mensajes de la empresa, consultar datos online, navegar, mantenerte comunicado con tu círculo laboral... Incluso he visto tiendas donde se aceptan pagos con móviles y si, también tablets.

El otro campo en donde los tablets se están haciendo un hueco es en el de ocio. Muchas redes sociales ya están optimizándose para tabletas digitales, y las empresas que sacan juegos o utilidades para tabletas se han multiplicado enormemente, lo que hace prever que el futuro de los ordenadores portátiles vaya decantándose del lado de las tablets.

Algunos precios:

Laptop

La primera computadora portátil considerada como tal fue la Epson HX-20 desarrollada en 1981, a partir de la cual se observaron los grandes beneficios para el trabajo de científicos, militares, empresarios, y otros profesionales, que vieron la ventaja de poder llevar con ellos su computadora con toda la información que necesitaban de un lugar a otro.

La Osborne 1 salió al mercado comercial en abril de 1981, que tuvo éxito para el comercio mayorista con el formato que actualmente las distingue, aunque entonces eran sumamente limitadas, incluso para la tecnología de la época.

En 1985 el Departamento I&D de CMET desarrolló Microtor I, un Computador Portátil basado en la CPU 6502, que fue el primero en incorporar un Módem Acústico, Display de Cristal Líquido e Impresora Térmica. El desarrollo fue lanzado en la Feria Internacional de Santiago FISA de ese año.

En 1995, con la llegada de Windows 95, la venta de las portátiles se incrementó notablemente, y en la actualidad rebasa las ventas de los equipos de escritorio.

En el tercer trimestre de 2008, las ventas de las portátiles superaron por primera vez las de los equipos de escritorio, según la firma de investigación iSuppli Corp.2

Importancia:

La importancia que tienen los computadores portátiles es que tienen mucha más ventaja que los computadoras normales, ya que una computadora personal suele estar equipada para cumplir tareas comunes de la informática moderna, es decir permite navegar por internet, escribir texto o realizar otros trabajos de oficina o educativos. Como editar textos y bases de datos, además de actividades de ocio como lo es escuchar música jugar por internet o investigar.

Algunos precios:

Dispositivos de Almacenamiento

Importancia:

Existen multitud de dispositivos diferentes donde almacenar nuestras copias de seguridad, desde un simple disco flexible hasta unidades de cinta de última generación. Evidentemente, cada uno tiene sus ventajas y sus inconvenientes, pero utilicemos el medio que utilicemos, éste ha de cumplir una norma básica: ha de ser estándar. Con toda probabilidad muchos administradores pueden presumir de poseer los streamers más modernos, con unidades de cinta del tamaño de una cajetilla de tabaco que son capaces de almacenar gigas y más gigas de información; no obstante, utilizar dispositivos de última generación para guardar los backups de nuestros sistemas puede convertirse en un problema: ¿qué sucede si necesitamos recuperar datos y no disponemos de esa unidad lectora tan avanzada? Imaginemos simplemente que se produce un incendio y desaparece una máquina, y con ella el dispositivo que utilizamos para realizar copias de seguridad. En esta situación, o disponemos de otra unidad idéntica a la perdida, o recuperar nuestra información va a ser algo difícil. Si en lugar de un dispositivo moderno, rápido y seguramente muy fiable, pero incompatible con el resto, hubiéramos utilizado algo más habitual (una cinta de 8mm., un CD-ROM, o incluso un disco duro) no tendríamos problemas en leerlo desde cualquier sistema Unix, sin importar el hardware sobre el que trabaja.

Aplicaciones:

Son todos aquellos aparatos que se utilizan para grabar los datos de la computadora de forma permanente o temporal. Una unidad de disco, junto con los discos que graba, es un dispositivo de almacenamiento. A veces se dice que una computadora tiene dispositivos de almacenamiento primarios (o principales) y secundarios (o auxiliares). Cuando se hace esta distinción, el dispositivo de almacenamiento primario es la Memoria de Acceso Aleatorio (RAM) de la computadora, un dispositivo de almacenamiento permanente pero cuyo contenido es temporal. El almacenamiento secundario incluye los dispositivos de almacenamiento más permanentes, como unidades de disco y de cinta.

La velocidad de un dispositivo se mide por varios parámetros: la velocidad máxima que es capaz de soportar, que suele ser relativa, en un breve espacio de tiempo y en las mejores condiciones; la velocidad media, que es la que puede mantener de forma constante en un cierto período de tiempo, y, por último, el tiempo medio de acceso que tarda el dispositivo en responder a una petición de información debido a que debe empezar a mover sus piezas, a girar y buscar el dato solicitado. Este tiempo se mide en milisegundos (ms), y cuanto menor sea esta cifra más rápido será el acceso a los datos.

No hay comentarios:

Publicar un comentario